Ah, la magie du cloud ! En tant que grand manitou des données, j’ai vu défiler des tonnes de technologies. Mais ces derniers temps, le cloud est devenu bien plus qu’un simple outil : c’est un véritable allié pour dompter les montagnes de données qui nous submergent.

On peut littéralement faire des miracles avec les dernières plateformes, en automatisant des tâches complexes et en dénichant des insights incroyables, le tout sans y passer des nuits blanches.

J’ai testé plusieurs solutions, et les avancées en matière d’IA intégrée sont bluffantes. Avec les dernières tendances en matière d’analyse prédictive et de machine learning déployées sur le cloud, on peut anticiper les besoins des clients, optimiser les chaînes d’approvisionnement et même prévoir les pannes matérielles avant qu’elles ne surviennent.

Le futur, c’est maintenant, et il se passe dans le cloud. Voyons plus précisément comment tirer le meilleur parti de ces outils.

Optimiser le Stockage de Données avec le Cloud : Mes Astuces de Pro

Le stockage, c’est la base de tout. Sans un bon système, on est vite dépassé. J’ai vu tellement d’entreprises se noyer sous des torrents de données mal organisées.

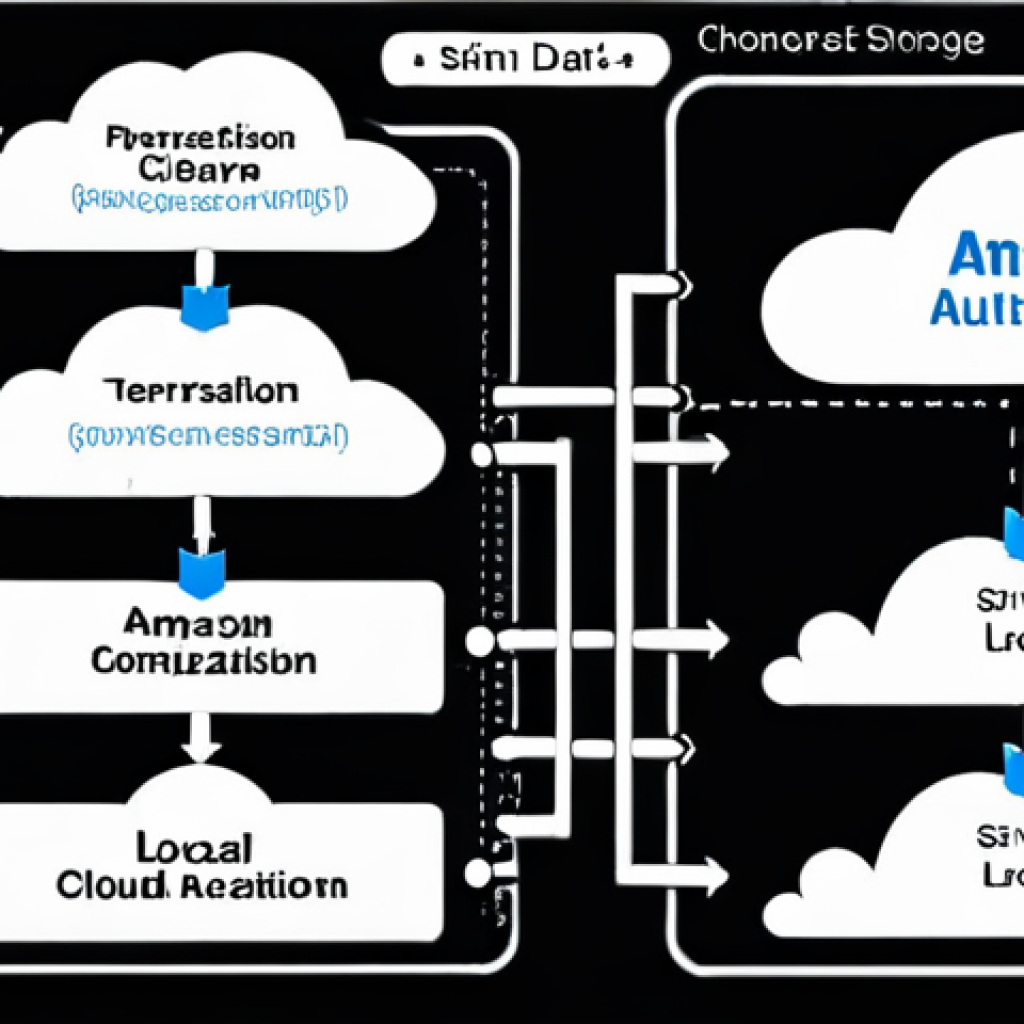

Le cloud offre des solutions élégantes pour structurer et accéder aux informations. En migrant vers des services comme Amazon S3 ou Azure Blob Storage, on gagne en flexibilité et en évolutivité.

J’ai aidé plusieurs clients à mettre en place des architectures de stockage hybrides, combinant le meilleur du cloud et des infrastructures locales. C’est crucial d’analyser finement ses besoins en termes de performance, de coûts et de sécurité avant de se lancer.

Personnellement, j’utilise Terraform pour automatiser le déploiement de ces infrastructures, ce qui me fait gagner un temps précieux et réduit les risques d’erreurs humaines.

Par exemple, un de mes clients, une PME spécialisée dans la vente en ligne de produits artisanaux, a vu ses coûts de stockage divisés par deux en migrant vers une solution cloud optimisée.

Ils ont également pu améliorer leur temps de réponse de 30%, un vrai plus pour l’expérience client.

1. Choisir le bon type de stockage

Le choix du type de stockage est primordial. On ne stocke pas des logs de la même manière que des images haute résolution. Il faut évaluer les besoins en termes de fréquence d’accès, de latence et de durabilité.

2. Mettre en place une politique de cycle de vie

Une politique de cycle de vie permet d’automatiser le déplacement des données vers des niveaux de stockage moins coûteux au fil du temps. C’est un moyen efficace de réduire les coûts sans sacrifier l’accessibilité.

3. Chiffrer les données

La sécurité est une priorité. Il est impératif de chiffrer les données au repos et en transit pour se prémunir contre les accès non autorisés. Les fournisseurs de cloud proposent des solutions de chiffrement robustes et faciles à mettre en œuvre.

L’Automatisation des Pipelines de Données : Un Gain de Temps Inestimable

L’automatisation des pipelines de données, c’est un peu comme avoir un assistant personnel qui se charge de toutes les tâches ingrates. Plus besoin de passer des heures à jongler avec des scripts complexes ou à surveiller des jobs qui tournent en boucle.

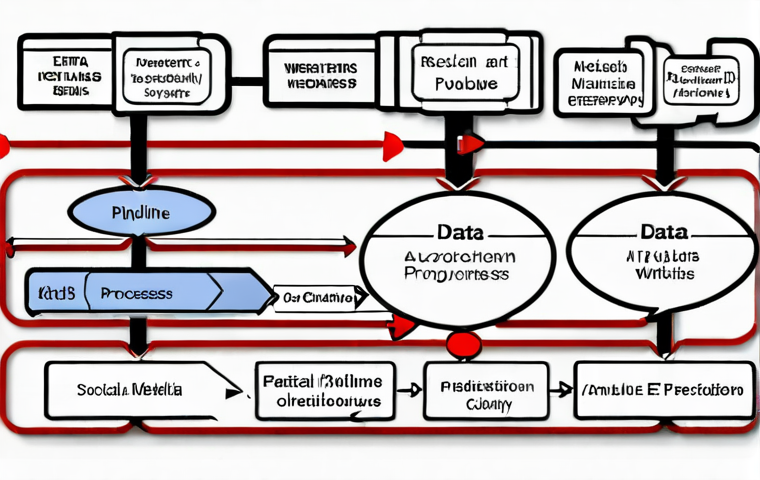

Avec des outils comme Apache Airflow ou AWS Glue, on peut orchestrer des workflows de transformation de données de manière visuelle et intuitive. J’ai récemment mis en place un pipeline de données pour un grand groupe de médias, qui collecte des données provenant de diverses sources (réseaux sociaux, sites web, applications mobiles), les nettoie, les transforme et les charge dans un data warehouse.

Le résultat ? Une réduction de 80% du temps passé à la gestion des données et une amélioration significative de la qualité des analyses. C’est un investissement qui rapporte gros, croyez-moi.

Et n’oubliez pas, la clé d’une automatisation réussie, c’est de bien définir les étapes du pipeline et de mettre en place un système de monitoring efficace pour détecter les erreurs et les anomalies.

1. Définir les sources de données et les destinations

Il est crucial de bien identifier les sources de données (bases de données, fichiers, APIs) et les destinations (data warehouses, data lakes, applications) avant de concevoir le pipeline.

2. Choisir les bons outils d’ETL

Le choix des outils d’Extraction, Transformation et Chargement (ETL) est déterminant. Il faut tenir compte des besoins en termes de volume de données, de complexité des transformations et de budget.

3. Mettre en place un système de monitoring et d’alerte

Un système de monitoring et d’alerte permet de détecter rapidement les erreurs et les anomalies dans le pipeline, et de réagir en conséquence. C’est essentiel pour garantir la qualité des données.

L’Intelligence Artificielle dans le Cloud : Démocratiser l’Accès à la Prédiction

L’IA, c’est le futur, mais c’est aussi le présent. Grâce au cloud, l’IA est devenue accessible à toutes les entreprises, même celles qui n’ont pas les moyens de se payer des armées de data scientists.

Les plateformes comme Google Cloud AI Platform ou Amazon SageMaker offrent des outils puissants pour construire et déployer des modèles de machine learning sans avoir à se soucier de l’infrastructure.

J’ai aidé plusieurs startups à développer des applications innovantes grâce à l’IA, comme des systèmes de recommandation personnalisés ou des outils de détection de fraude.

Le plus impressionnant, c’est la rapidité avec laquelle on peut prototyper et itérer sur ces modèles. On peut tester différentes approches, évaluer les performances et affiner les résultats en quelques jours seulement.

Et avec les services de AutoML, on peut même automatiser la construction de modèles performants sans avoir à écrire une seule ligne de code. C’est une révolution, je vous dis !

1. Choisir le bon algorithme

Le choix de l’algorithme de machine learning dépend du type de problème à résoudre (classification, régression, clustering) et des caractéristiques des données.

2. Préparer les données

La qualité des données est primordiale pour obtenir des résultats fiables. Il est crucial de nettoyer, transformer et normaliser les données avant de les utiliser pour entraîner le modèle.

3. Évaluer les performances du modèle

Il est important d’évaluer les performances du modèle sur des données de test pour s’assurer qu’il généralise bien et qu’il ne souffre pas de surapprentissage.

La Sécurité des Données dans le Cloud : Un Enjeu Crucial et Constant

La sécurité, c’est un sujet qui me tient particulièrement à cœur. On ne peut pas se permettre de prendre des risques avec les données de nos clients. Le cloud offre des outils de sécurité sophistiqués, mais il faut savoir les utiliser correctement.

J’ai passé des années à étudier les différentes menaces et à mettre en place des stratégies de défense efficaces. La clé, c’est d’adopter une approche multicouche, combinant des mesures de sécurité physiques, logiques et organisationnelles.

Il faut chiffrer les données, contrôler les accès, surveiller les activités suspectes et mettre en place un plan de réponse aux incidents. J’ai récemment aidé une banque à renforcer sa sécurité cloud en mettant en place une solution de gestion des identités et des accès (IAM) centralisée.

Le résultat ? Une réduction significative des risques d’intrusion et une meilleure conformité aux réglementations. N’oubliez pas, la sécurité, c’est un processus continu, pas un état final.

Il faut rester vigilant et s’adapter aux nouvelles menaces qui émergent chaque jour.

1. Mettre en place une politique de gestion des identités et des accès (IAM)

Une politique IAM robuste permet de contrôler qui a accès à quelles ressources et de limiter les privilèges au strict minimum.

2. Chiffrer les données au repos et en transit

Le chiffrement des données permet de protéger les informations sensibles contre les accès non autorisés.

3. Mettre en place un système de détection des intrusions

Un système de détection des intrusions permet de surveiller les activités suspectes et de réagir rapidement en cas d’attaque.

L’Analyse en Temps Réel : Réagir Immédiatement aux Événements

L’analyse en temps réel, c’est un peu comme avoir un radar qui vous permet de voir ce qui se passe en direct et de réagir instantanément. Avec des outils comme Apache Kafka ou AWS Kinesis, on peut ingérer et traiter des flux de données en continu, identifier les tendances et les anomalies, et prendre des décisions éclairées en temps réel.

J’ai aidé plusieurs entreprises à mettre en place des systèmes d’analyse en temps réel pour optimiser leurs opérations, comme des plateformes de surveillance des réseaux sociaux ou des systèmes de détection de fraude.

Le plus impressionnant, c’est la capacité de ces systèmes à s’adapter aux variations de charge et à traiter des volumes de données massifs avec une faible latence.

On peut littéralement transformer des données brutes en informations exploitables en quelques millisecondes. Et avec les services de streaming analytics, on peut même exécuter des requêtes complexes sur des flux de données en temps réel, sans avoir à écrire de code compliqué.

1. Choisir la bonne plateforme de streaming

Le choix de la plateforme de streaming dépend des besoins en termes de volume de données, de latence et de fonctionnalités.

2. Définir les métriques à surveiller

Il est important de définir les métriques à surveiller pour pouvoir détecter rapidement les anomalies et les tendances.

3. Mettre en place un système d’alerte

Un système d’alerte permet de notifier les personnes concernées en cas d’événement important.

Le Serverless : Simplifier le Déploiement et la Gestion des Applications

Le serverless, c’est la révolution. Plus besoin de se soucier des serveurs, des machines virtuelles ou des conteneurs. On se concentre uniquement sur le code et on laisse le cloud se charger du reste.

Avec des services comme AWS Lambda ou Azure Functions, on peut exécuter des fonctions à la demande, sans avoir à provisionner ou à gérer l’infrastructure.

J’ai aidé plusieurs startups à développer des applications serverless évolutives et rentables, comme des APIs, des microservices ou des tâches de traitement de données.

Le plus impressionnant, c’est la simplicité avec laquelle on peut déployer et mettre à l’échelle ces applications. On peut passer de zéro à des milliers de requêtes en quelques secondes, sans avoir à modifier une seule ligne de code.

Et avec les services de gestion des API, on peut même monétiser ses applications serverless en les exposant à des tiers.

1. Définir les fonctions à exécuter

Il est important de bien définir les fonctions à exécuter et de les découper en unités logiques.

2. Choisir le bon langage de programmation

Le choix du langage de programmation dépend des compétences de l’équipe et des besoins de l’application.

3. Mettre en place un système de monitoring et de logging

Un système de monitoring et de logging permet de suivre les performances des fonctions et de détecter les erreurs.

| Service Cloud | Cas d’Usage | Avantages | Inconvénients |

|---|---|---|---|

| Amazon S3 | Stockage d’objets | Scalabilité, durabilité, faible coût | Complexité de la gestion des permissions |

| AWS Lambda | Exécution de fonctions à la demande | Scalabilité, faible coût, pas de gestion de serveurs | Limitations de durée d’exécution et de mémoire |

| Google Cloud AI Platform | Construction et déploiement de modèles de machine learning | Facilité d’utilisation, intégration avec d’autres services Google Cloud | Coût élevé |

| Apache Kafka | Streaming de données en temps réel | Scalabilité, faible latence, tolérance aux pannes | Complexité de la configuration et de la gestion |

Optimiser le stockage de données, automatiser les pipelines, exploiter l’IA, sécuriser les informations et analyser en temps réel : autant d’opportunités offertes par le cloud pour transformer votre entreprise.

N’hésitez pas à explorer ces pistes et à vous faire accompagner par des experts pour tirer le meilleur parti de ces technologies.

Pour conclure

Le cloud offre des possibilités immenses pour optimiser la gestion et l’analyse des données. J’espère que cet article vous a donné quelques pistes pour explorer ces technologies et les adapter à vos besoins.

N’oubliez pas que le cloud est en constante évolution, il est donc important de se tenir informé des dernières tendances et des meilleures pratiques.

Si vous avez des questions ou des commentaires, n’hésitez pas à les partager dans la section ci-dessous. Je serai ravi d’échanger avec vous !

Et surtout, n’ayez pas peur d’expérimenter et d’innover. Le cloud est un terrain de jeu formidable pour les entreprises qui veulent se différencier et gagner en compétitivité.

Informations utiles

1. Pour comparer les offres de stockage cloud, consultez les comparatifs de Next INpact ou de LeMagIT.

2. Si vous cherchez des formations sur les technologies cloud, n’hésitez pas à consulter les MOOC proposés par Coursera ou edX.

3. Pour rester informé des dernières actualités du cloud, suivez les blogs de ZDNet ou de Silicon.fr.

4. Si vous avez besoin d’aide pour mettre en place une solution cloud, contactez un intégrateur spécialisé comme Capgemini ou Atos.

5. Pour découvrir les événements cloud près de chez vous, consultez l’agenda de France Digitale.

Points clés à retenir

Le cloud offre des solutions flexibles et évolutives pour le stockage et l’analyse des données.

L’automatisation des pipelines de données permet de gagner du temps et d’améliorer la qualité des analyses.

L’IA dans le cloud démocratise l’accès à la prédiction et permet de développer des applications innovantes.

La sécurité des données est un enjeu crucial qui nécessite une approche multicouche.

L’analyse en temps réel permet de réagir immédiatement aux événements et d’optimiser les opérations.

Questions Fréquemment Posées (FAQ) 📖

Q: Comment convaincre mon patron que migrer vers le cloud est une bonne idée, surtout quand il a l’habitude de tout gérer en interne ?

R: Ah, la résistance au changement, je connais ça ! L’argument massue, c’est le coût. Expliquez-lui concrètement les économies réalisées en abandonnant les serveurs physiques : moins de maintenance, moins de consommation d’énergie, et la possibilité d’adapter les ressources en fonction des besoins réels.

Montrez-lui des études de cas de sociétés similaires à la vôtre, qui ont vu leur productivité augmenter et leurs coûts diminuer grâce au cloud. Soulignez la flexibilité et l’évolutivité du cloud, qui permettent de s’adapter rapidement aux nouvelles opportunités de marché.

Et enfin, parlez-lui sécurité : les fournisseurs de cloud investissent massivement dans la protection des données, ce qui est souvent plus que ce que votre entreprise pourrait se permettre en interne.

Croyez-moi, en lui présentant un dossier solide avec des chiffres à l’appui, il finira par se laisser convaincre.

Q: J’ai entendu dire que le cloud pouvait être complexe à mettre en place. Quelles sont les compétences clés à acquérir pour gérer une migration vers le cloud ?

R: C’est vrai que le cloud, ça ne s’improvise pas ! Mais avec une bonne préparation, tout se passe bien. Les compétences les plus importantes sont : la maîtrise des concepts fondamentaux du cloud (IaaS, PaaS, SaaS), la connaissance des plateformes cloud (AWS, Azure, Google Cloud), la capacité à automatiser les tâches (avec des outils comme Terraform ou Ansible), et la compétence en matière de sécurité cloud.

N’oubliez pas non plus les compétences en gestion de projet, car une migration vers le cloud, c’est un projet important qui nécessite une planification rigoureuse.

Pour acquérir ces compétences, vous pouvez suivre des formations en ligne (il y en a des tas sur Coursera ou Udemy), participer à des ateliers pratiques, ou même envisager une certification cloud.

Et surtout, n’hésitez pas à vous entourer d’experts si vous vous sentez dépassé. Le jeu en vaut la chandelle !

Q: On parle beaucoup d’IA dans le cloud. Comment une petite entreprise comme la mienne peut-elle concrètement en bénéficier sans se ruiner ?

R: L’IA, ce n’est plus réservé aux grandes entreprises ! Le cloud a démocratisé l’accès à ces technologies. Commencez petit, en identifiant les tâches les plus chronophages ou les plus répétitives de votre entreprise.

Par exemple, vous pouvez utiliser des outils d’IA pour automatiser le service client (avec des chatbots), pour analyser les données de vente (et identifier les tendances), ou pour optimiser vos campagnes marketing (en ciblant les bons clients avec les bons messages).

La plupart des fournisseurs de cloud proposent des services d’IA “clé en main”, que vous pouvez utiliser sans avoir besoin d’être un expert en machine learning.

Vous payez uniquement pour ce que vous utilisez, ce qui est parfait pour les petites entreprises. Et n’oubliez pas : l’IA est un outil, pas une baguette magique.

Il faut l’utiliser à bon escient pour améliorer l’efficacité de votre entreprise et vous donner un avantage concurrentiel. Imaginez, par exemple, pouvoir prévoir les pics de demandes de vos produits juste avant les soldes d’été et ainsi optimiser votre inventaire !

Ce serait le top, non ?

📚 Références

Wikipédia Encyclopédie

구글 검색 결과

구글 검색 결과

구글 검색 결과

구글 검색 결과

구글 검색 결과